Google ML Bootcamp/5. Sequence Models

9. Gate Recurrent Unit(GRU)

코딩소비

2023. 9. 26. 13:56

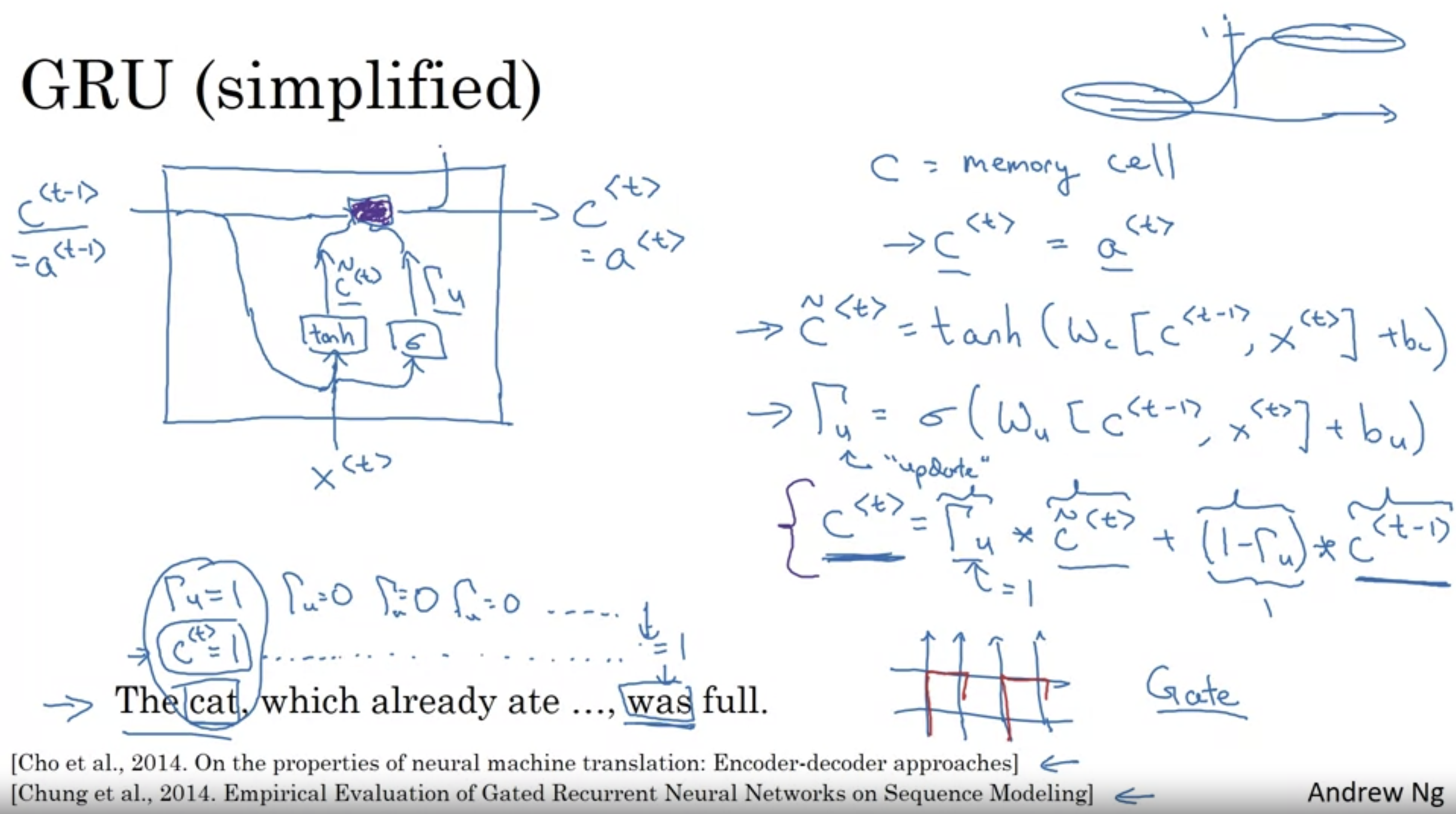

목적 : RNN이 가지고 있는 Gradient Vanishing 문제를 해결하기 위해.

- 기존 Deep Neural Network 구조에서 Gradient Vanishing 문제를 해결하기 위해서는 weight random initization이 효과적이라고 설명한 바 있다.

- 그러기 위해 도입한 Gate 개념과 C<t-1> 변수에 대해 이해하자.

The cat, which already ate ~ , was full

- 해당 예시에서 was/were를 결정하기 위해서는 처음에 등장한 Cat 이라는 주어가 매우 중요하다.

- 따라서 which, already, ate 등 시점의 C<t>일때 감마 update 값은 0이라면(0에 근접한다면) was를 출력할 때 주어가 cat임을 참고할 수 있다.

GRU, LSTM 목적:

- RNN의 Long Term dependency 문제를 해결하기 위해(Gradient Vanishing 문제에서 비롯된)