17. Learning Word Embeddings

2023. 9. 27. 14:32ㆍGoogle ML Bootcamp/5. Sequence Models

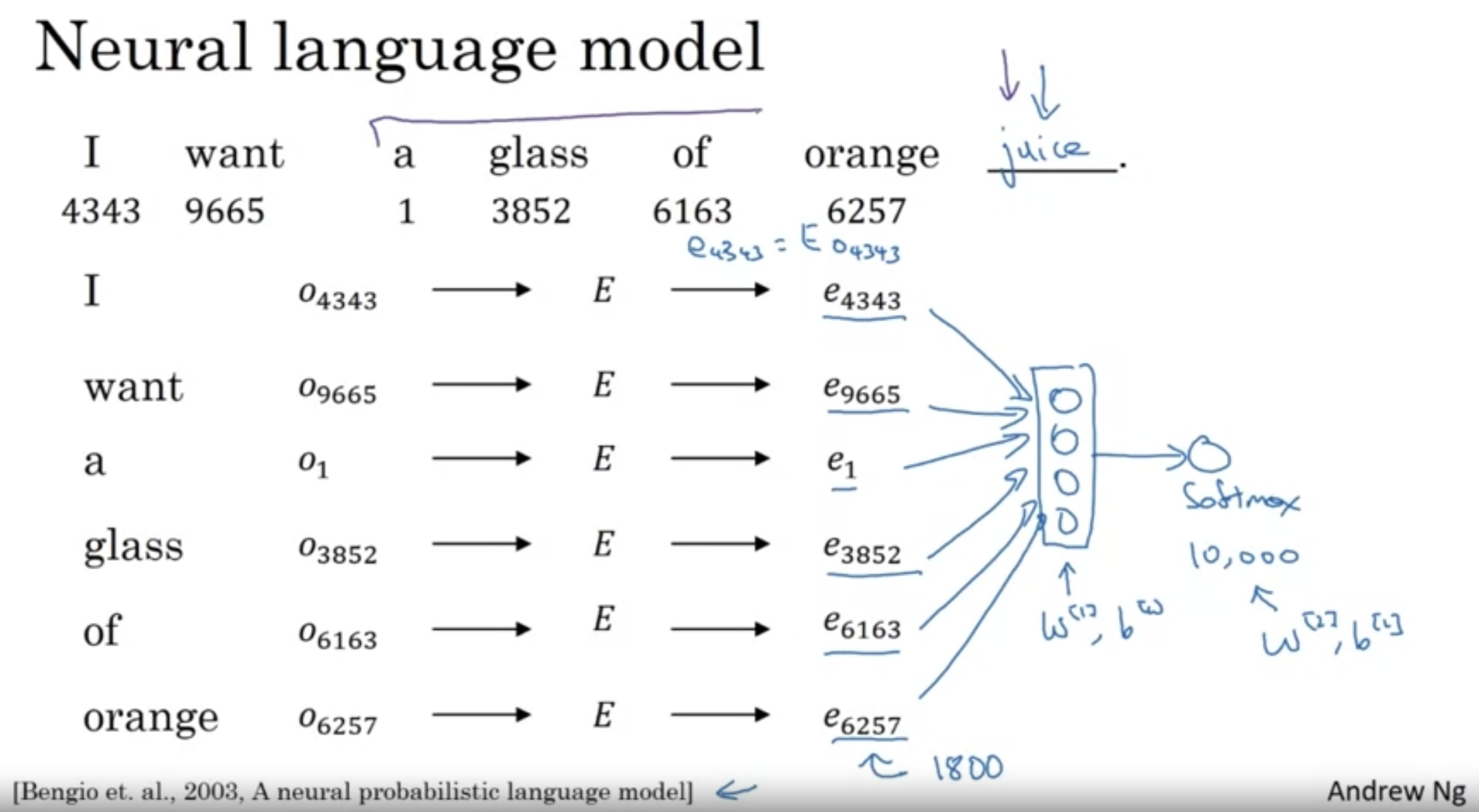

word embedding matrix로 부터 각 단어의 featurized vector(300 features)를 얻고, 이를 Input으로 하는 마지막 layer를 거쳐 마지막 softmax(vocabulary size)를 통해 next word prediction을 수행한다.

- 이때 next word prediction 시 앞의 몇 개의 단어를 참고할 건지는 hyperparameter로 설정 가능.

- 6개의 단어를 참고하여 juice 를 예측하려면 300 feature를 가친 6개의 단어를 참고하기 때문에 마지막 layer input size는 1800.

'Google ML Bootcamp > 5. Sequence Models' 카테고리의 다른 글

| 19. Negative Sampling (0) | 2023.09.27 |

|---|---|

| 18. Word2Vec (0) | 2023.09.27 |

| 16. Embedding Matrix (0) | 2023.09.27 |

| 15. Properties of Word Embeddings (0) | 2023.09.27 |

| 14. Using Word Embeddings (0) | 2023.09.27 |