30. Gradient Descent for Neural Networks

2023. 9. 9. 15:05ㆍGoogle ML Bootcamp/1. Neural Networks and Deep Learning

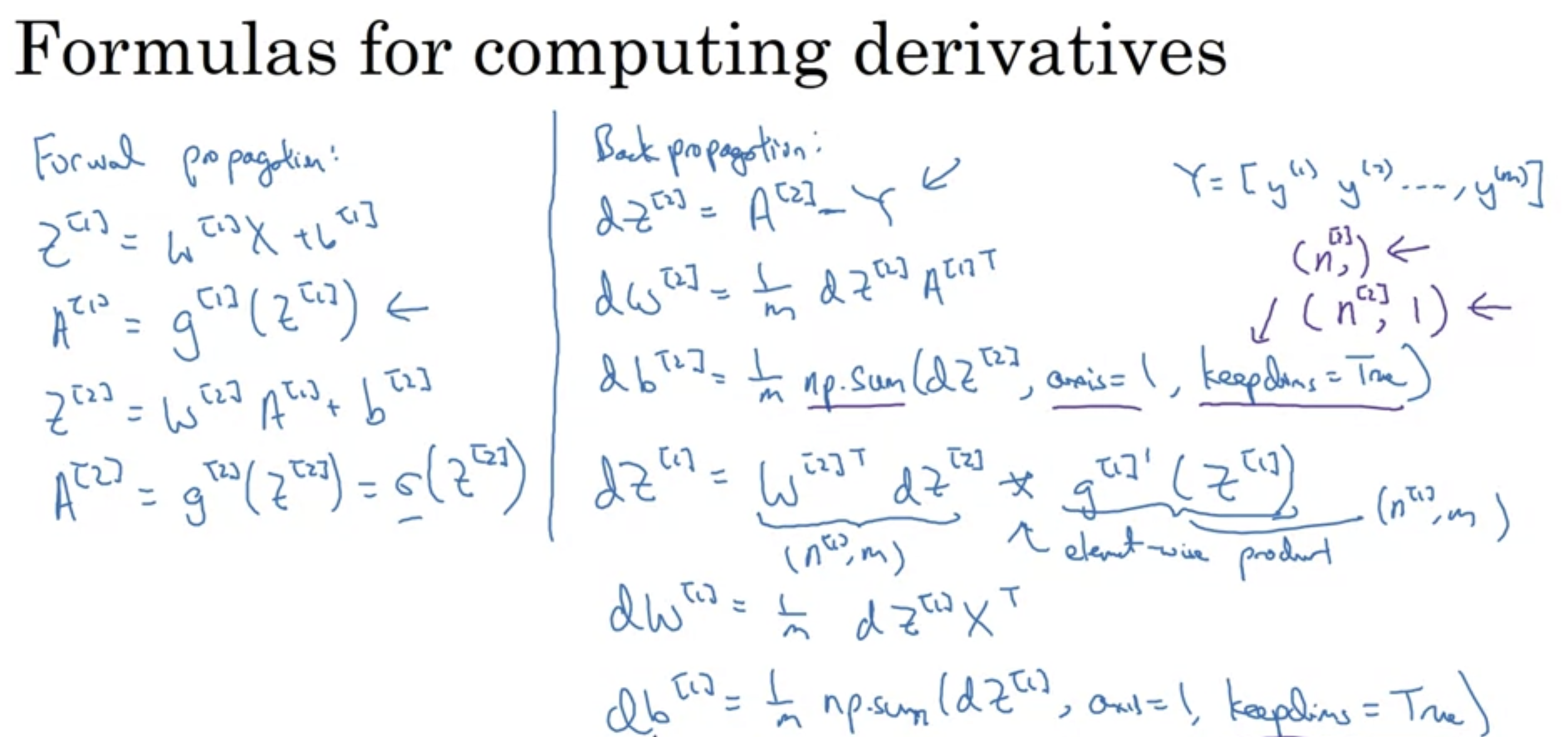

Gradient Descent

-input : x.shape (nx,1) = n[0], n[1], n[2] -> input layer, hidden layer, output layer존재.

-params : w[1], b[1], w[2], b[2]

-cost function : J(w[1], b[1], w[2], b[2]) = 1/m * np.sum(y-y*)

1. y* 계산

2. dw, db 계산.

3. w[1], b[1], w[2], b[2] update

4. 1-3 과정 반복.

dw[2]의 경우 input이 A[1]이므로 1/m * np.dot(dz[2], A[1].T)

- 도함수이므로 의미? 해당 변수 dw[2]가 변했을 때 y*(A[2])에 영향을 미치는 정도 at A[1] = A[1]에서의 기울기

'Google ML Bootcamp > 1. Neural Networks and Deep Learning' 카테고리의 다른 글

| 32. Random Initialization (1) | 2023.09.09 |

|---|---|

| 31. Backpropagation Intuition (Optional) (0) | 2023.09.09 |

| 29. Derivatives of Activation Functions (0) | 2023.09.09 |

| 28. Why do you need Non-Linear Activation Functions? (0) | 2023.09.09 |

| 27. Activation Functions (0) | 2023.09.09 |