13. Classic Networks

2023. 9. 15. 22:22ㆍGoogle ML Bootcamp/4. Convolutional Neural Networks

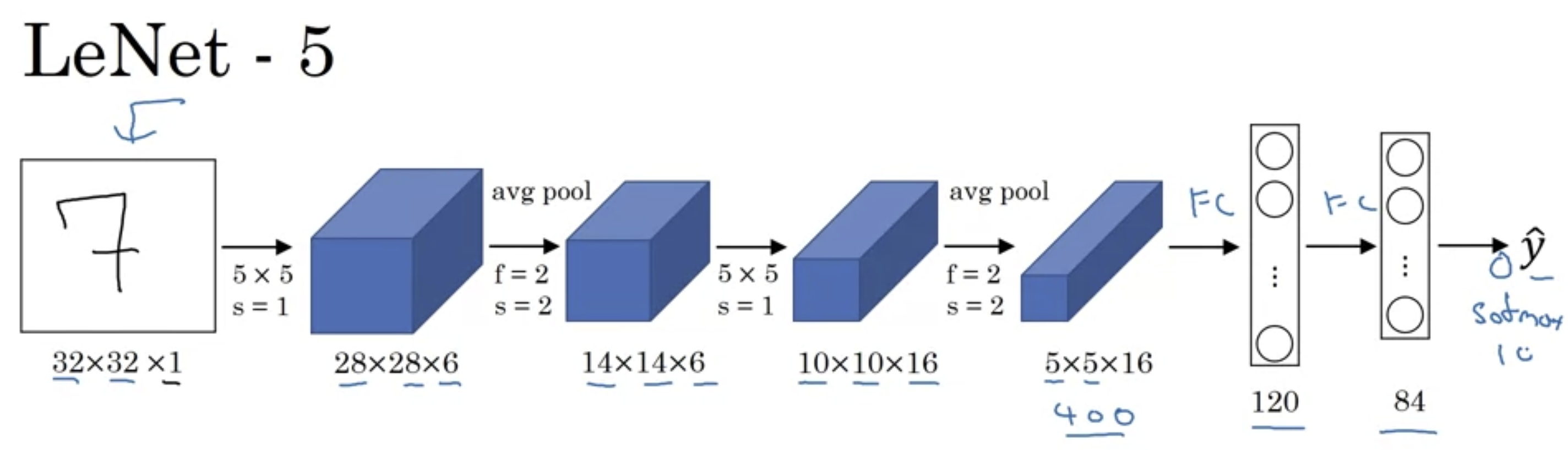

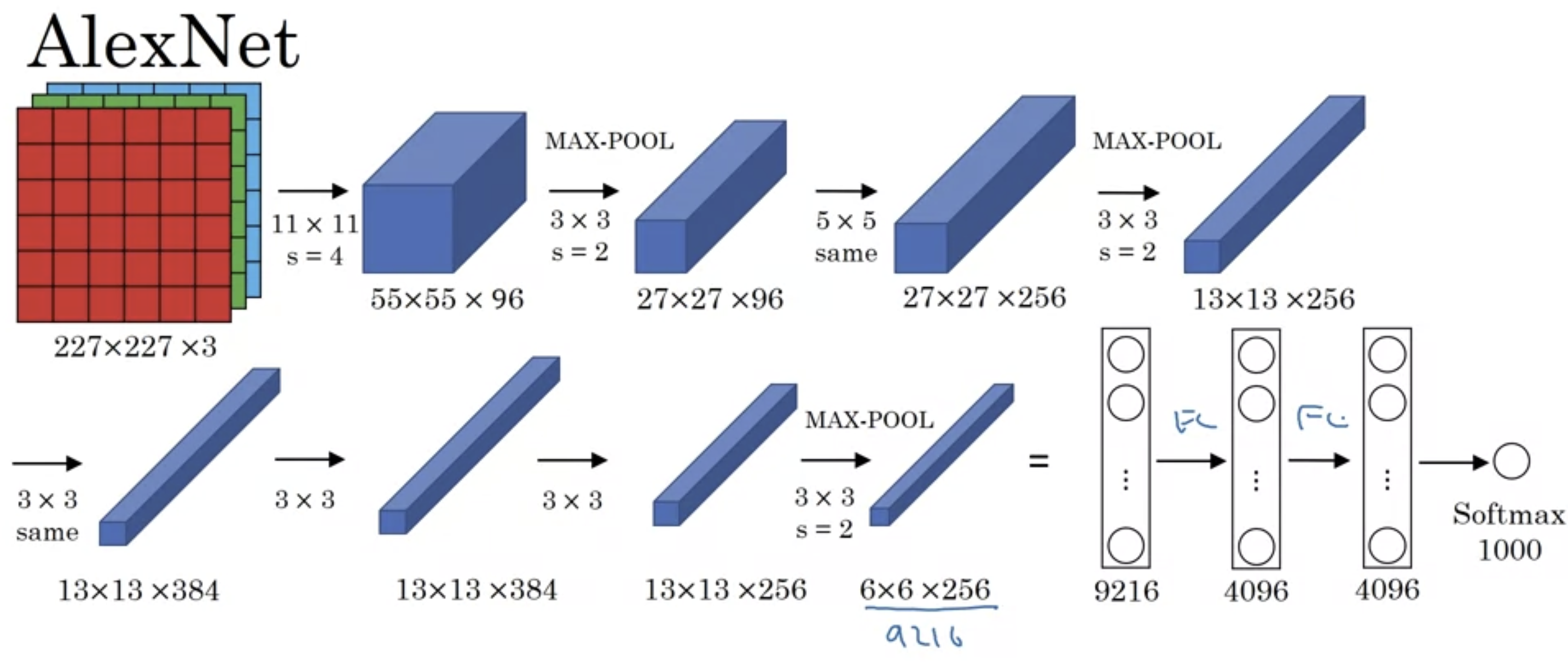

네트워크가 깊어질수록 height와 width는 줄어드는 것을 볼 수 있다.

반대로 number of channels는 증가한다.

Conv -> pool -> Conv -> pool -> F.C -> F.C -> softmax

- 꽤 일반적인 CNN 구조.

LeNet 논문을 읽게 된다면 오히려 요즘에는 쓰지 않아도 되는(컴퓨팅 파워가 증가) 기법들로 구현이 되어 조금 더 읽기 어려움을 주의.

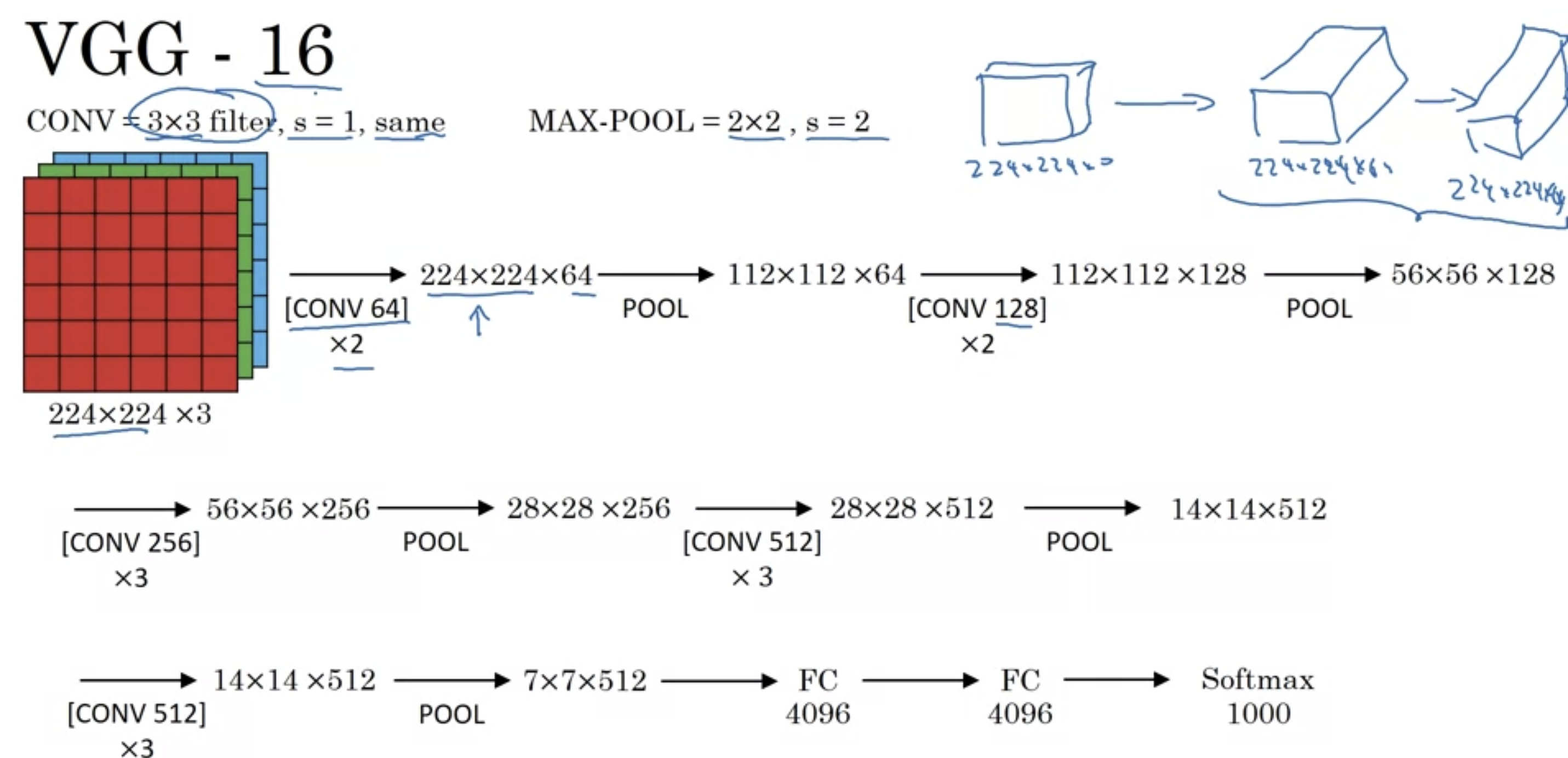

height, width가 2배 감소하는동안 number of channels는 2배 증가.

- 상당히 매력적인 구조. 안정적이잖아!

'Google ML Bootcamp > 4. Convolutional Neural Networks' 카테고리의 다른 글

| 15. Why ResNets Work? (0) | 2023.09.15 |

|---|---|

| 14. ResNets (0) | 2023.09.15 |

| 12. Why look at case studies? (0) | 2023.09.15 |

| 11. Why Convolutions? (0) | 2023.09.15 |

| 10. CNN Example (0) | 2023.09.15 |